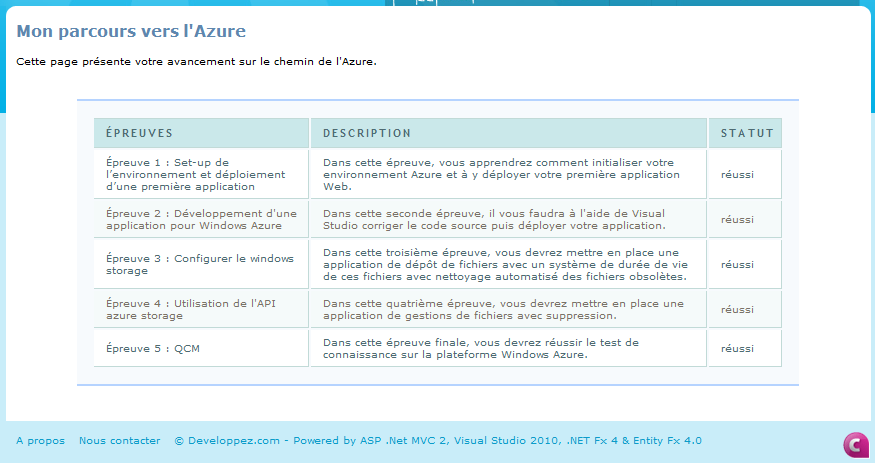

lundi 21 décembre 2009

samedi 17 octobre 2009

Le Monstre

Et oui, le Patch Tuesday d'octobre est tout simplement ... monstrueux ! Avec 13 bulletins corrigeant 33 failles, c'est un record dans l'histoire des bulletins de sécurité Microsoft.

Il faut dire que traditionnellement, avant chaque lancement d'une nouvelle version de Windows, Microsoft vide son placard des failles accumulées. Et Windows Seven sort le 22 octobre ...

Impossible de rentrer dans les détails techniques de tous ces correctifs en un seul billet. Je me contenterai de donner quelques remarques ou anecdotes concernant ces bulletins.

MS09-050 corrige 3 failles dans l'implémentation du protocole SMBv2: celle trouvée par Laurent Gaffié (qui n'est pas crédité, en châtiment de son irresponsible disclosure), et une autre faille exploitable trouvée par Matthieu Suiche (l'un de mes anciens stagiaires :). Notons que ces deux français sont expatriés: l'un au Canada, l'autre aux Pays-Bas.

MS09-051 corrige des failles dans un obscur codec de Windows Media, optimisé pour le traitement de la voix. Mais ce bulletin est symptomatique du fait qu'il faut lire les bulletins, et pas seulement appliquer les correctifs. En effet, ce codec n'est pas présent par défaut dans Windows Media Player 6.4 sur Windows 2000, mais a pu être installé par le mécanisme de recherche automatique des codecs en ligne. Si c'est le cas, une opération manuelle est requise sur le poste.

MS09-053 corrige des failles (déjà connues) dans le serveur FTP de Microsoft. Bizarrement, Kingcope est crédité alors que la publication de ces failles a été tout sauf responsable !

MS09-054 est un correctif cumulatif pour Internet Explorer. L'une des failles est exploitable par le biais de la technologie XBAP: il ne s'agit rien de moins que de créer des applications complètes (en code managé) qui vont être téléchargées et exécutées dans le navigateur ! Un remplacement des ActiveX et un concurrent pour la technologie Native Client de Google.

Là où ça devient fort, c'est que l'installation du Framework .NET 3.5 (pré-requis à l'exécution d'applications XBAP) va automatiquement installer une extension Firefox (si ce navigateur est présent). Donc même Firefox sur Windows est vulnérable à cette faille ! Du coup, la fondation Mozilla a désactivé cette extension par le biais des mises à jour automatiques de plugins ... Est-ce que Microsoft va réactiver le plugin par le biais de Windows Update ?

MS09-056 corrige deux failles dans la CryptoAPI (le pendant Windows de la libssl), permettant de tricher sur les propriétés d'un certificat. Manque de chance, ce correctif n'est pas compatible avec le produit Microsoft OCS - un produit de communication unifiée très en vogue actuellement: il provoque l'invalidation des clés de licence ...

MS09-061 permet basiquement d'exécuter du code "natif" depuis du code "managé", même si celui-ci s'exécute avec les droits minimum. Il s'agit d'une évasion de machine virtuelle comme Java en a connu par le passé. Dès lors que vous exécutez du code "managé" depuis une source non sûre, vous êtes exposés: applications XBAP, hébergement ASP.NET, mais aussi plugin SilverLight (le concurrent Microsoft d'Adobe Flash Player). Ce dernier est un produit important dans le portfolio Microsoft ...

L'auteur de l'un de ces bogues (Jeroen Frijters) n'en est pas à son coup d'essai. Pour la petite histoire, il est leader d'un projet Open Source visant à implémenter une machine Java en .NET (le projet IKVM). Dans le cadre de ce projet, il a déjà remonté plusieurs bogues critiques à Microsoft, qui ont tous été corrigés silencieusement. Du coup, il avait décidé d'appliquer ce qu'il appelle la "no Microsoft bug filing policy". Il faut croire que Microsoft s'en est ému.

PS. Si vous vous demandez à quoi peut bien servir une machine Java en .NET, sachez qu'il en existe déjà une, fournie par Microsoft: il s'agit de la technologie J#. C'est très pratique lorsque Microsoft fait l'acquisition d'applications entièrement écrites en Java ;) Seul problème: cette technologie a été développée à Hyderabad et s'avère ni fiable (d'après Jeroen Frijters), ni pérenne (d'après Wikipedia).

MS09-062 corrige un paquet de failles dans GDI+. Pour mémoire, GDI+ est la librairie qui traite tous les formats d'image sous Windows - l'impact potentiel de ces failles est donc énorme, compte-tenu du nombre de vecteurs d'attaque. Souvenez-vous, déjà en 2004 certains avaient prédit le "Big One" avec la faille JPEG dans cette même librairie (MS04-028).

Comme facteur aggravant, il faut noter que le code GDI+ est disponible sous forme de librairie dans les outils de développement Microsoft. Il est donc possible de lier statiquement ce code à toute application développée avec Visual Studio. Conclusion: malgré la mise à disposition par Microsoft (à l'époque) d'un outil de recherche de motifs dans le code compilé, il est impossible de venir entièrement à bout de cette faille dans toutes les applications tierces.

Notons que l'une de ces failles permet d'exécuter du code "natif" depuis du code "managé" (évasion du Framework .NET). Java a connu les mêmes: il s'agit d'un risque rampant, sauf à réécrire toutes les librairies graphiques en code managé.

Notons aussi que Thomas Garnier (SkyRecon) est crédité pour la découverte de l'une de ces failles. Sachant qu'il a quitté SkyRecon autour du mois de février 2009 (pour aller chez Microsoft), cela donne une idée du délai de correction de cette faille ... La faille dans les graphiques Office a été vendue à iDefense en avril 2008, et celle sur le format TIFF en ... décembre 2007 !

Que conclure de tout cela ?

Je ne vais pas employer un mot commençant par "E..." pour ne pas lasser mes lecteurs. Mais quand même, mettre plus d'un an à corriger des failles, corriger silencieusement des failles critiques dans le Framework .NET (exploitables à distance via SilverLight), introduire des failles dans des applications tierces comme Firefox ... ça la fout mal pour les champions du développement sécurisé ...

Pour finir, félicitations aux équipes de Google et Palo Alto Networks pour le nombre de failles qu'elles ont trouvées ! (Ce dernier étant un pare-feu innovant qui a fait du buzz lors des Assises de la Sécurité).

Posted by newsoft at 10:00:00

mercredi 7 octobre 2009

Pourquoi la sécurité ne va pas s'améliorer

Il n'a échappé à personne que 10,000 mots de passe Hotmail ont été "aperçus" sur le site pastebin.com. Pour ceux qui ne connaissent pas, PasteBin est un site gratuit et anonyme permettant d'échanger rapidement des données textuelles entre amis et avec le monde entier par la même occasion. Ce qui est l'occasion de voir parfois à quel point les gens sont confiants ...

L'origine de cette divulgation est probablement liée à une campagne de phishing.

Comme à chaque fois qu'une base importante de mots de passe est perdue, c'est l'occasion d'enrichir ses connaissances sur les pratiques des utilisateurs confrontés au problème crucial du choix d'un mot de passe.

Malheureusement, dans le cas de Hotmail comme dans tous les cas antérieurs (ex. phpbb.com), le mot de passe le plus courant est ... "123456".

Qu'est-ce que cela m'inspire ? Qu'après avoir lutté pendant des années pour mettre en place des politiques de robustesse sur les mots de passe dans les entreprises (c'est même une recommandation forte ou une exigence dans la plupart des normes et standards comme PCI/DSS ou ISO 2700x), le Web 2.0 nous fait revenir 20 ans en arrière.

La différence, c'est que le Web 2.0 a des clients là où les entreprises ont des utilisateurs. Et même si les utilisateurs sont (parfois) pénibles, on peut les contraindre à obéir. Alors que le client est roi ...

La situation est même pire que cela, puisque les clients du Web 2.0 sont les annonceurs. L'utilisateur, lui, ne paie rien et ne s'engage à rien (les contrats transnationaux signés par un simple clic sur "oui, j'accepte" n'ayant probablement aucune valeur légale). Il est donc essentiel de choyer l'utilisateur pour qu'il n'aille pas voir ailleurs. Et dans ce domaine, imposer des mots de passe complexes est tout sauf user-friendly.

Dans le Web 2.0, c'est le marketing qui arbitre sur les exigences de sécurité. Les informaticiens ayant une activité professionnelle à forte composante technique, qui se sont retrouvés rattachés du jour au lendemain à une direction marketing (j'en connais beaucoup), apprécieront l'impact potentiel ...

Quelques-uns, comme MySpace, imposent une relative complexité sur le mot de passe (lettres ET chiffres). Résultat: le mot de passe le plus commun sur ce site est ... "password1" (on notera au passage que les "gens normaux" commencent à compter à partir de 1, et non 0 comme tout informaticien qui se respecte :).

Est-ce que cela impacte les entreprises d'une manière ou d'une autre ? Je ne vais pas me lancer dans des débats sur l'informatique nébuleuse (Cloud Computing) ou la dépendance cachée à GMail ...

Mais quand on voit le nombre de sites institutionnels qui utilisent Google Analytics, sans que la politique sécurité de l'entreprise ne soit applicable au mot de passe choisi ... le fait que la majorité des gens réutilisent le même mot de passe partout ... et la dépendance chainée entre les différents services 2.0 par le biais de la réinitialisation de mot de passe (comme dans le cas emblématique de Twitter) ... je suis quand même vaguement inquiet, et pas du tout confiant dans le fait que les choses vont s'améliorer !

Posted by newsoft at 14:00:00

samedi 19 septembre 2009

L'échec de Microsoft

Dans Windows, il n'y a que 3 points d'entrée à défendre:

- La pile TCP/IP

- L'implémentation SMB (sur les ports TCP/139 et/ou TCP/445)

- L'implémentation du RPC endpoint mapper (port TCP/135)

Il est possible de n'avoir aucun port ouvert sur l'extérieur (moyennenant quelques astuces telles que la configuration de la clé de base de registre "ListenOnInternet"), mais en pratique je n'ai jamais vu une machine configurée de la sorte ailleurs que dans les labos de recherche.

Avec Windows Vista (sorti en novembre 2006, pour mémoire), Microsoft a modifié deux composants fondamentaux:

- La pile TCP/IP, entièrement réécrite pour supporter nativement IPv6.

- L'implémentation SMB, passée en version 2. Cette version est supposée plus simple (donc plus sûre) avec seulement 16 commandes au lieu de 80.

Ca sentait pourtant mauvais, puisque la pile IP s'est d'abord avérée partiellement vulnérable à la Land Attack (avant la sortie de la RTM), puis une faille conceptuelle dans l'implémentation de la signature SMB a obligé Microsoft à mettre à jour le protocole en version 2.1 (bulletin de sécurité MS07-063).

- On ne peut avoir confiance en personne. Malgré un budget de 4 milliards de dollars pour le développement de Vista, le recrutement de toutes les pointures en sécurité disponibles sur le marché, et des objectifs affichés en matière de sécurité, Microsoft a raté[*] une faille assez triviale (à détecter, pas à exploiter :) et catastrophique en terme d'impact.

- Il n'y a eu aucune analyse correcte de la faille sur Internet. Je n'ai vu que SourceFire et ReverseMode aborder le sujet sous un angle vaguement technique, sans toutefois rentrer dans les détails. Ca ne veut pas dire que personne ne comprend rien - ça veut dire que les gens qui travaillent sérieusement sur cette faille ne sont pas payés pour faire fuir les détails sur leur blog ...

- Par contre des gens pour réécrire le code d'exploitation en Java et s'accorder tous les crédits, il y en a eu. J'attends la version PHPCLI ...

- Les loups sont lâchés. Je prédis d'autres failles sur SMBv2 (bon là je triche un peu ;).

- Et vive la France, puisque tous les acteurs de la chaine sont francophones ! Laurent Gaffié (on m'a dit qu'il était québecois, mais je ne le connais pas personnellement), Kostya Kortchinsky et Nicolas Pouvesle.

Posted by newsoft at 09:00:00

mardi 15 septembre 2009

Je suis fâché contre Dell

Ces derniers temps, mes collègues et moi avons eu plusieurs expériences malheureuses avec Dell: délais de livraison allongés de manière incompréhensible, supports technique et commercial totalement inutiles, disponibilité des pilotes Vista plusieurs mois après la sortie du matériel (alors que la machine est livrée par défaut sous Vista), conception matérielle douteuse (ex. connecteurs trop fragiles), etc.

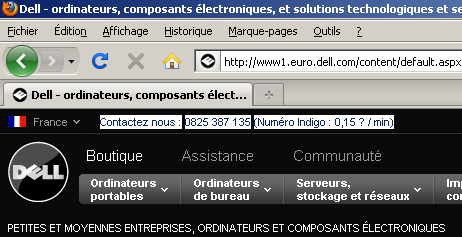

Mais sur le site de Dell, franchement, on est à la limite de l'escroquerie:

Ecrire le tarif de la hotline en noir sur fond noir, ça ne doit pas être très légal, surtout à 0,15€/mn.

Edit: pour les gens qui ne veulent pas installer Flash (excellente idée au demeurant) ou qui ne peuvent pas installer Flash, voici les screenshots.

Posted by newsoft at 10:00:00

vendredi 4 septembre 2009

Message aux lecteurs de DC

- Les "mouchards numériques" imaginés dans LOPPSI 2. Si le mouchard est logiciel, une confrontation inévitable va s'en suivre avec les éditeurs antivirus (et assimilés). Il n'est pas sûr que l'Etat arrive à développer des backdoors indétectables sur le long terme par tous les outils de contrôle d'intégrité du marché.

- La détection des téléchargements illégaux dans le cadre de la loi HADOPI. La collecte et le traitement des données ont été confiés à une société privée. Quelles conséquences si cette base de données (voire le système en amont chez les FAI) est compromise ?

- La CSPN. Ce qui au départ devait être une certification administrative de type Critères Communs (tous ceux qui se présentent finissent par l'avoir ... tôt ou tard !) se transforme ni plus ni moins en une collecte de failles d'implémentation dans des produits COTS (un ZDI-like français ? Mais que va faire VUPEN !). Je ne peux pas croire que seuls 3 produits se soient présentés depuis la création de cette certification: l'Etat doit donc disposer d'un sacré stock de "0day" :) Car par expérience: "tout produit qui n'est pas un produit de sécurité, et qui n'a pas été conçu par des gens de la sécurité, est truffé de failles de sécurité" ...

- L'ANR SEC&SI. Ou comment essayer de régler le problème des malwares sur Internet en proposant à Mme Michu un système ultra-sécurisé, permettant de lire son mail, d'ouvrir des documents (Open)Office et de surfer sur Internet en toute confiance. C'est une lourde responsabilité pour l'éditeur d'une telle solution, comme en ont fait les frais les Chinois avec leur logiciel de filtrage Green Dam. La mission n'est pas totalement impossible, si on oublie tout critère d'ergonomie et de convivialité (laissez tomber Flash) ... mais Windows Seven n'est-il pas déjà assez sécurisé pour ce qu'on fait sur Internet ? ;)

Posted by newsoft at 08:00:00

lundi 24 août 2009

L'envers du décor

- Ils sont incontournables (Flash, toutes versions confondues, dépasse les 99% de déploiement dans le monde).

- Ils font l'objet de problèmes de sécurité récurrents.

- Ils sont accessibles via un navigateur.

- En conséquence ... ils sont ciblés par de vraies attaques provenant d'Internet.

En ce qui concerne Acrobat Reader, c'est l'enfer.

Quand je dis ".msi", il faut comprendre une version compressée avec NOSSO dans laquelle il est possible de trouver le ".msi" après quelques manipulations (notez que la documentation d'installation d'Acrobat Reader est elle-même au format PDF :) ... Sans parler de la version anglaise d'Acrobat Reader, qui installe également AIR si l'on n'y prend garde.

- Le parser de fichiers ".adm" étant ce qu'il est, il faut obligatoirement terminer par un retour à la ligne (sinon le dernier caractère de la dernière ligne est omis).

- Les clés de base de registre n'étant pas des sous-clés de "Software\Policies" ne sont pas affichées par défaut. Il faut changer le filtre d'affichage dans la GPMC.

- La sécurité est un échec.

- Il est impossible d'être un bon auditeur sans être un excellent administrateur.

- Personnellement, je désinstalle Flash à chaque annonce de faille pour être sûr de toujours récupérer la dernière version au moment où j'en ai vraiment besoin.

- Et enfin, le réseau de ma femme est probablement plus sûr que celui des entreprises du CAC40 ... la sécurité est un échec, à nouveau !

Posted by newsoft at 08:00:00

lundi 17 août 2009

Faut-il passer à Windows Seven ?

Très franchement, je n'en sais rien :) Mais la question se pose, puisque 2 personnes proches, n'ayant jamais acheté de logiciel auparavant, se sont payés un Windows Seven en précommande.

Posted by newsoft at 08:00:00

vendredi 7 août 2009

Casser du WPA comme l'élite

Posted by newsoft at 08:00:00

lundi 27 juillet 2009

La preuve que la sécurité est un échec

Pour ceux qui ne lisent pas (ou plus) la liste de diffusion Full Disclosure, voici la version courte de l’histoire : un « groupe » se faisant appeler « anti-sec » lance une guerre totale contre les « white hats » (les gentils hackers, si toutefois cela a un sens) et le « full disclosure ». Une telle initiative refait surface de manière périodique, la dernière en date étant le « pr0j3kt m4yh3m » (tout un programme).

Comme preuve de leur motivation, ils ont saccagés quelques sites à forte visibilité : Astalavista, ImageShack … le dernier en date étant la crème du consulting américain en sécurité informatique : la société Matasano.

Cette histoire est emblématique à plusieurs titres.

Tout d’abord la réponse à « pourquoi la sécurité est un échec » se voit une n-ième fois confortée : toutes ces attaques sont basées sur la découverte d’un mot de passe faible par brute-force SSH, n’en déplaise à ceux qui pensaient avoir trouvé un « 0day » exploitable en préauth dans SSH sur un Linux 64 bits avec le patch GrSecurity appliqué …

N’oublions pas le cas de Twitter, qui aurait pu simplement « disparaitre » du Web à la suite de la compromission d’un mot de passe (heureusement que cette attaque était le fruit d’un individu isolé plutôt bien intentionné).

Ensuite le cas de Matasano laisse songeur, surtout lorsqu’on voit que le même système est utilisé pour de l’hébergement Web, de la messagerie … et le stockage de données d’audit client (ex. « ISA Pen Test Availability_13_Feb.xls »).

La sécurité est un échec car personne, quel que soit son niveau de compétences et l’énergie investie dans l’administration de ses systèmes, ne peut prétendre être invulnérable. D’ailleurs vous ne m’entendrez jamais dire « fu^H^Hhack me I’m famous », car je sais trop bien que vous y arriveriez :)

Des exemples ?

On lit dans la presse que divers réseaux de sensibilité extrême sont piratés (DoD, FAA, système de paiement, …). C’est bien sûr totalement invérifiable, mais crédible. Ayant eu l'occasion de m'intéresser à quelques réseaux sensibles vaguement connectés à Internet (SITA, réseaux satellitaires, etc.), il s’avère qu’ils sont tous de même niveau de sécurité que le réseau bureautique moyen … l’expérience des attaques en moins !

Prenons quelques exemples publics et vérifiables :

- Le site « j’aime les artistes ». Un(e) ministre ayant commis l’erreur de prétendre ce site inviolable, il a été immédiatement mis hors d’usage.

- La société « Extelia ». Après avoir gagné l’appel d’offres HADOPI, cette société et tous ses sites clients ont immédiatement été piratés.

- Le (défunt) Challenge Securitech. Bien sûr faire converger tous les « experts en sécurité » français (soyons clair, Securitech était devenu très « corporate » sur la fin :) sur un site où ils peuvent gagner un iPod en piratant était dangereux. Mais se faire avoir parce que l’hébergeur a désactivé l’option « magic quotes » est un peu humiliant quand même :)

- Le blog d’Ivanlef0u. En même temps, je ne vois pas qui peut assurer la sécurité d’un hébergement mutualisé en PHP. Ils serait plus facile de compiler OpenOffice sous OpenBSD.

- Edit: n'oublions pas la fameuse démo du projet SPAClik au SSTIC'09. "Aucune faille n'a été trouvée dans mon système jusqu'à présent". On connait la suite, avec l'humiliation en direct sur scène.

Ainsi dans mon cas, je suis dépendant de :

- La sécurité de ma Freebox (autant dire pas grand-chose, puisqu’elle est administrable à distance par au moins tout le personnel de Free).

- La sécurité de mes fournisseurs de messagerie (Free, Gmail, etc.). Autant dire pas grand-chose non plus, même si j’utilise de fausses réponses aux questions secrètes, que je ne lis jamais mon mail via l’interface Web, et que j’utilise un mot de passe différent sur chaque site. Car réaliser un Webmail sécurisé relève de la mission impossible.

- La sécurité de mes machines à la maison. Ainsi « on » m’a fait remarquer que dans la configuration Debian par défaut du serveur ProFTDd, l’utilisateur anonyme peut accéder à tout le disque par un simple « ../ ». Mais qui fait encore confiance à Debian pour assurer sa sécurité ? :)

Alors que peut-on faire ? Rien du tout, car en général il suffit que l’un de ces maillons soit brisé pour que le château de cartes s’écroule par le jeu des relations de confiance. La meilleure défense consiste à ne rien stocker de sensible qui ne soit accessible en ligne, car tout ce qui est connecté à Internet est ou peut être compromis.

Pour tenter une analogie (avec tous les risques que cela comporte), les digicodes ne servent à rien quelle que soit la longueur du code - à partir du moment où au moins un résident de l'immeuble a déjà commandé une pizza par téléphone (disclaimer: je n'ai jamais audité le réseau Pizza Hut, je suppose juste que tous les digicodes sont stockés en clair dans leur base de données :).Posted by newsoft at 08:00:00

vendredi 24 juillet 2009

Psychose

Pour commencer, il vous faut écouter cette séquence avec attention (il s'agit d'un distributeur de billets de marque Diebold situé à Paris, strictement identique à tous les distributeurs déployés par la Société Générale en France):

Posted by newsoft at 08:00:00

vendredi 3 juillet 2009

L'échec de la sécurité française

- Kostya Kortchinsky

- Nicolas Pouvesle

- Thomas Garnier

- Julien Tinnès

- Julien Vanègue

- Remote Root sur les LiveBox (ne rigolez pas, ça a existé)

- VIGIK: comment ouvrir toutes les serrures avec une clé privée

- Sécurité du pass Navigo (sur le modèle de Mobib Extractor)

- Sécurité du site des impôts (ou comment économiser de l'argent en supprimant les certificats)

- La backdoor dans SecurityBox (pudiquement appelée "clé de recouvrement/séquestre" dans l'étude publiée par HSC)

- Etc.

Posted by newsoft at 08:00:00

lundi 29 juin 2009

IKEArt

Je suis en vacances en ce moment, ce qui explique que je ne blogue pas (et que je ne suis pas à Hacker Space Festival). Mais ne vous inquiétez pas, j'ai toujours des choses à dire !

Posted by newsoft at 16:38:00

mercredi 27 mai 2009

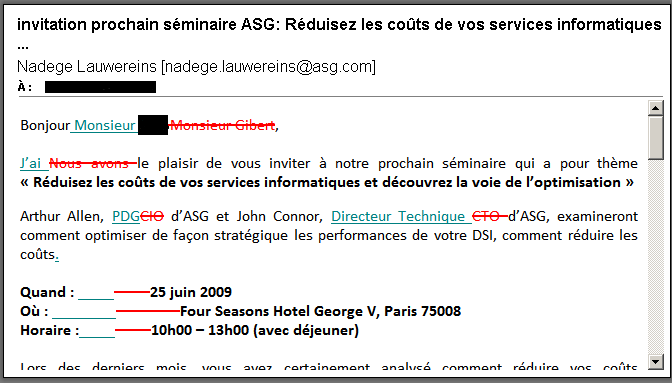

Spam fail

Posted by newsoft at 22:20:00

vendredi 22 mai 2009

Un avis d'expert sur HADOPI

Déjà être expert ça n'est pas grand chose - après tout il y en a environ 325 millions d'après Google. Pas comme les Senior Experts, les Executive Experts ou les Technical Evangelists :)

- Contrôler le serveur source (par exemple, mettre en place un faux serveur eDonkey). Cette solution - pratiquée par des sociétés comme MediaSentry - est légalement douteuse et ne passe pas à l'échelle, vu la prolifération de l'offre.

- Contrôler le réseau. Une solution très alléchante, mais qui présente deux inconvénients: elle ne supporte pas la cryptographie ; et elle nécessite une infrastructure technique de filtrage et de journalisation (à valeur probante) considérable, pour laquelle ni l'Etat ni les FAI ne sont prêts à payer.

- Contrôler le client final. Cette solution résout les deux problèmes précédents. C'est un peu le Cloud Computing appliqué à la cyber-surveillance :)

Posted by newsoft at 21:08:00

mardi 7 avril 2009

Rien n'est laissé au hasard

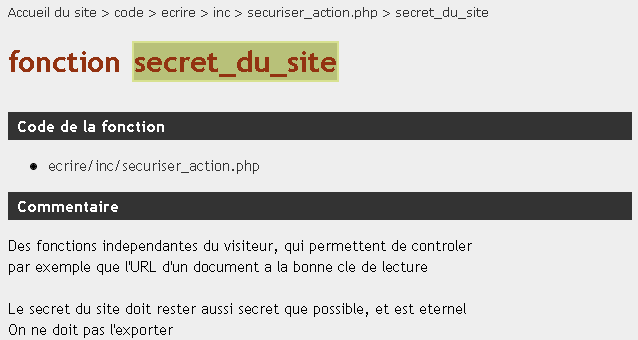

Ceux qui m'ont déjà lu ou entendu savent que je ne manque jamais une occasion de dire que "PHP est la pire régression pour la sécurité depuis 10 ans"(tm).

Posted by newsoft at 21:10:00

samedi 28 mars 2009

Futurologie

En 2006, j'avais imaginé que les protocoles P2P puissent être utilisés comme canal de contrôle résilient par des botnets.

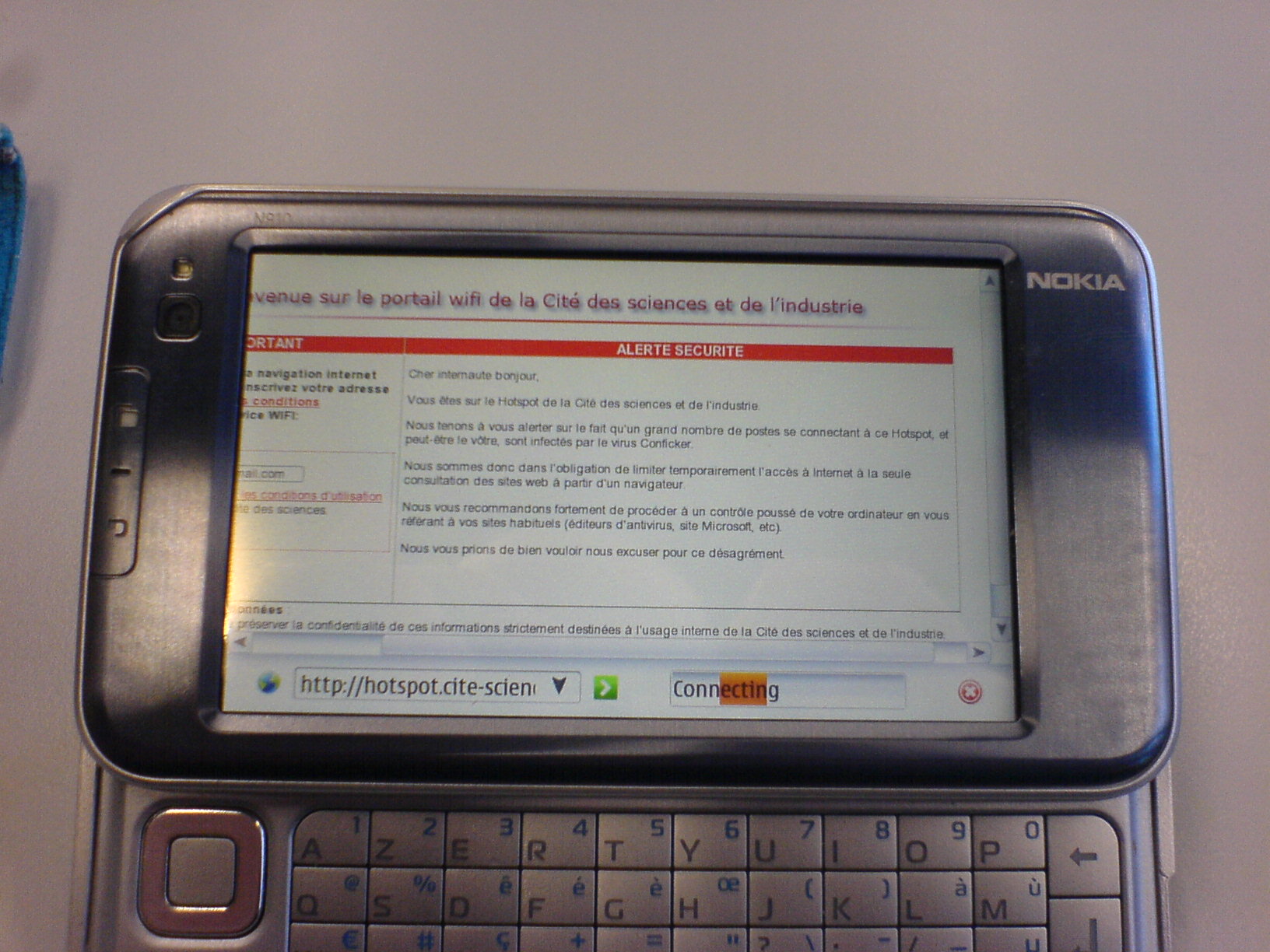

La Freebox est invulnérable face à cette attaque. Selon Free, il n’y a "aucune chance." ;)

- Failles d'implémentation dans la plupart des modems/routeurs du marché [1] [2] [3]

- Librairie Open Source non maintenue depuis 2006 (encore utilisée dans de nombreux modems/routeurs du marché).

- Nouvelle librairie Open Source présentant un historique loin d'être vierge (notez le subtil "Bugfix for M-Search packet" tout en bas).

Posted by newsoft at 22:49:00

samedi 7 mars 2009

Les gens ne lisent plus (ils jackent)

- Le visiteur qui s'est perdu ici en utilisant Ethicle, le moteur de recherche qui plante des arbres ...

- Le site Niouzes, qui syndique le newsgroup "comp.os.linux" (trollomètre au taquet). J'ai le privilège d'y être cité au moins 2 fois [1][2]. Là où ça devient fort, c'est que la référence à ma bâche sur \LaTeX ... est illisible à cause de l'encodage utilisé sur le site (UTF-8 probablement ;).

- Enfin, le meilleur d'entre tous, le site de Jacques, alias *Jack. Mythique.

Posted by newsoft at 23:00:00

vendredi 13 février 2009

Random Rants Against Microsoft

Menu Démarrer > Paramètres > Personnel > Aujourd'hui > Image d'arrière plan

Il faut savoir que Windows "Seven" a pour numéro de version interne ... 6.1

PS. Pour Internet Explorer, la gestion des versions est encore pire - puisqu'à peu près toutes les versions de navigateur s'installent sur toutes les versions supportées de Windows (XP / Vista / Seven). Alors si vous voulez comprendre comment ça marche, rendez-vous sur le blog Internet Explorer.

- Les speakers Microsoft donnent en général l'impression de découvrir les slides (fraichement traduits de l'anglais) à l'écran.

- Pas un mot sur Vista cette année ! Comme dirait un collègue, "dans 10 ans on le confondra avec Windows ME".

- Et surtout ... goodies fail cette année :(

- C'est gratuit et bien situé.

- Tout le monde y est.

- On peut jouer avec la table Surface (j'ai hâte d'avoir ça dans mon salon).

- C'est un mélange improbable entre geeks boutonneux (souvent étudiants) et hôtesses comme on en voit pas dans les salons Open Source.

11h : Table ronde* Général Yves Mathian, ancien Directeur Technique de la DGSE* Commandant Nicolas Duvinage, Chef d'escadron(...)15h30 : Conférence underground : "Vulnérabilités et exploitations avancées"

Posted by newsoft at 18:00:00